Panorama du contexte réglementaire et des initiatives IA de confiance

2023 devrait être l’année de l’adoption de l’AI Act par la Commission Européenne, près de 2 ans après la proposition de loi sur l’encadrement des systèmes d’IA parue en avril 2021(1). Ce contexte réglementaire, couplé à de multiples initiatives nouvelles ou grandissantes en 2022, répond à une croissance exponentielle du nombre de cas d’usages IA sur le marché et à la nécessité d’en maîtriser les risques associés. Dans cet article, nous vous proposons un panorama du contexte et des initiatives IA de confiance qui ont émergé ou se sont déployées en 2022.

Une explosion du nombre de systèmes d’IA industrialisés et des risques associés

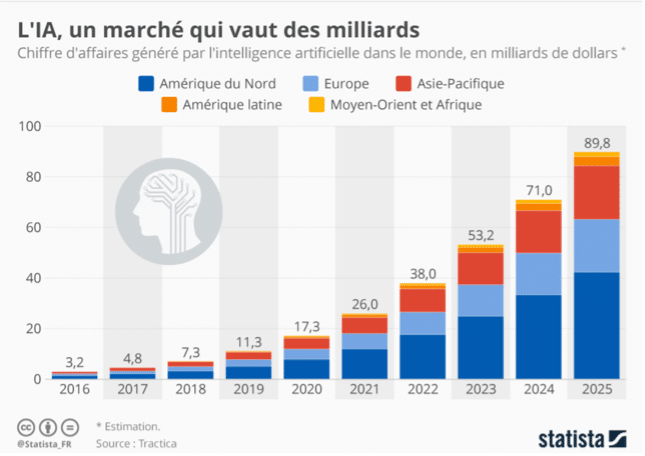

Tout d’abord, on observe une forte croissance du nombre de cas d’usages IA développés et industrialisés depuis les années 2010, avec une forte accélération depuis environ 5 ans (2). Par exemple, le taux d’industrialisation moyen des cas d’usage IA est passé 27% à 46% entre 2021 et 2022 selon notre « Baromètre 2022 des Organisations Data Quantmetry » (3). Cette croissance, estimée à plus de 53 milliards de dollars en 2023 dans le monde (2), concerne en particulier l’Amérique du Nord, suivie de l’Europe et de l’Asie- Pacifique avec des pays leaders, selon l’OCDE, tels que les Etats-Unis, la Chine, les pays de l’Union Européenne et notamment le Royaume-Uni, l’Allemagne, la France, ou encore dans une moindre mesure, Israël (4).

Estimation du chiffre d’affaires généré par l’IA dans le monde, en milliard de dollars, Statista, 2022

Toutefois, cette croissance s’accompagne d’une hausse proportionnelle des risques inhérents à l’IA lorsque ceux-ci ne sont pas maîtrisés, entraînant des dérives voire des accidents. Tesla par exemple a vu l’un de ses véhicules Tesla Model 3 être la cause d’un accident mortel après avoir accéléré sans laisser la possibilité à son conducteur de freiner, comme le conducteur le précisera dans son dépôt de plainte (5). Cet accident ayant eu lieu dans le 13ème arrondissement de Paris en décembre 2021 a causé la mort d’un piéton et la prise en charge d’une vingtaine de personnes par les secours. Une enquête est en cours pour déterminer la responsabilité de Tesla ou du conducteur dans cet accident.

On peut penser que ce type de scandale touche particulièrement les GAFAMs, étant connus pour être à l’état de l’art en termes d’IA, mais ce n’est pas le cas. En effet, tout type d’acteur développant des modèles d’IA peut être concerné, comme des institutions par exemple. Ce fut le cas de la Ville d’Amsterdam qui vît la démission de son gouvernement (6) après que 26 000 parents bénéficiant d’allocations familiales aient été accusés à tort de fraude fiscale à cause d’un algorithme se basant sur profilage ethnique des personnes ; des critères discriminants tels que la double nationalité ou le lieu d’habitation ayant été utilisés pour estimer les niveaux de risque de fraude.

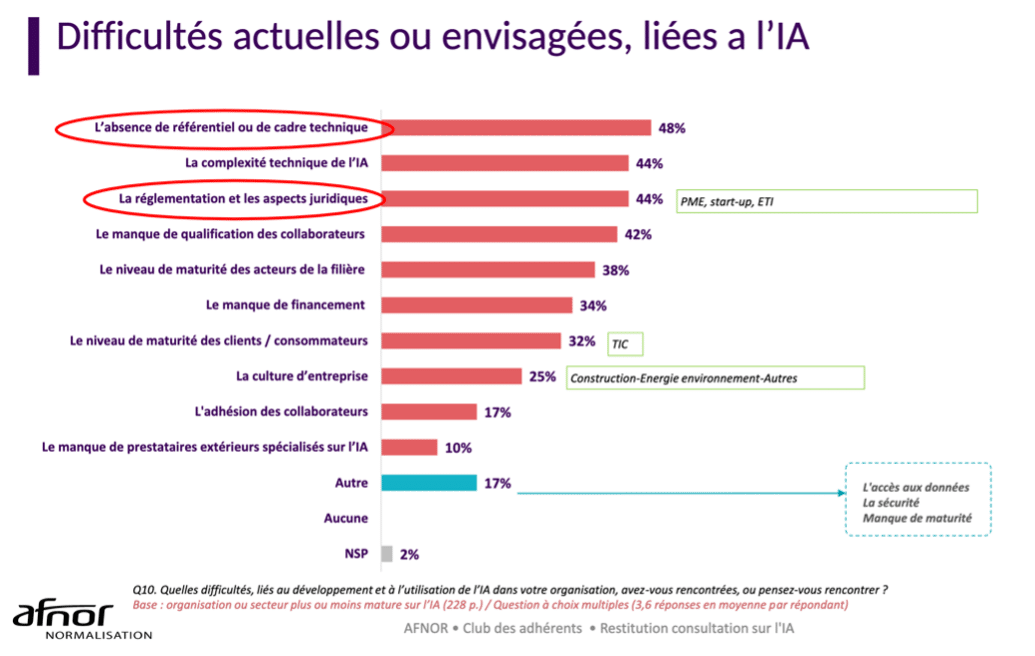

Ces dérives ou accidents montrent que le développement et le déploiement des systèmes d’IA nécessitent aujourd’hui un cadre légal et technique pour garantir l’intégrité, la sécurité, la santé et la liberté des personnes. C’est ce que rapportait également le panel de dirigeants interrogés lors la consultation nationale sur l’intelligence artificielle réalisée par l’AFNOR en 2021 (7) : « l’absence de référentiel ou de cadre technique rendent difficiles le développement ou l’utilisation de l’IA dans notre organisation ».

Restitution de la consultation nationale sur l’IA AFNOR, novembre 2021

Réponse à la question 10 : « Quelles difficultés, liées au développement ou à l’utilisation de l’IA dans votre organisation, avez-vous rencontrées, ou pensez-vous rencontrer ? »

Un boom des initiatives pour une IA de confiance

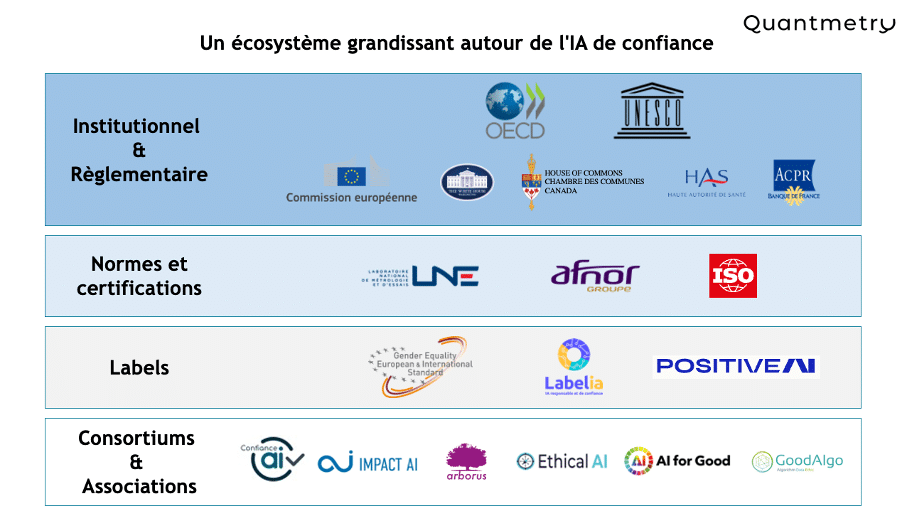

Sur la base de la multiplication des scandales, de l’inquiétude grandissante des concitoyens et de l’urgence de cadrer les systèmes d’IA de plus en plus nombreux pour mieux accompagner l’innovation, de multiples initiatives voient le jour au niveau européen mais aussi mondial. Une synthèse non exhaustive de ces initiatives (projets de loi, normes volontaires, certifications, labélisations ou collectifs) est proposée ici.

Au niveau réglementaire, le futur AI Act de la Commission Européenne cadre les systèmes d’IA identifiés comme « critiques », c’est-à-dire engendrant un niveau de risque élevé d’atteinte à l’intégrité et aux droits fondamentaux des personnes. Cette approche basée sur les risques (8) concerne les pays européens mais également les pays déployant des systèmes d’IA à destination des citoyens européens, sur la base du principe d’extraterritorialité (9). Pour accompagner cette proposition de cadre légal, la Commission Européenne recommande aux organisations souhaitant se mettre en conformité le recours à la grille d’évaluation des niveaux de risques construite par l’OCDE (10). Des initiatives comparables voient le jour aux Etats-Unis notamment, avec le projet de régulation des systèmes d’IA au niveau fédéral, l’Algorithmic Accountability Act (11) pour centraliser et harmoniser un contexte réglementaire dynamique mais morcelé actuellement. En effet, une quinzaine de projets de lois sont en cours de travail dans plusieurs États et villes, notamment sur des sujets ayant un fort impact sociétal, tels que la restriction de la reconnaissance faciale ou du recrutement automatisé. Dans le même sens au Canada, un projet de loi, l’Artificial Intelligence and Data Act(12) (AIDA) vise à définir les pré-requis pour la conception, le développement et le déploiement d’IA alignés avec les standards nationaux et internationaux et d’interdire les usages d’IA risqués pour les individus et leurs intérêts.

En parallèle, un ensemble de normes volontaires sur l’IA sont définies ou en cours de définition. C’est le cas d’une trentaine de normes sur lesquelles contribue le groupe de travail international ISO/IEC JTC 1/SC 42 (13). Les normes « ISO/IEC 24030 : use cases » (14), « ISO/IEC 24027 : assessing biais » (15), « ISO/IEC 24028 : overview of trustworthiness » (16) ou encore « ISO/IEC 24029-1 overview for robustness assessment of neural network » (17) sont déjà disponibles. D’autres sont en cours d’écriture telles que la norme « ISO/IEC 23894 Guidance on risk management » (18) qui permettra l’analyse et l’évaluation des risques sur la base d’un référentiel de risk management adapté à l’IA. En France, le LNE (19) lance en 2021 la certification de processus pour l’IA reposant sur l’analyse de l’ensemble des processus du cycle de vie des systèmes d’IA.

Les secteurs d’activité français s’emparent également du sujet. En 2020, l’Autorité de Contrôle Prudentiel et de Résolution (ACPR) a travaillé sur un référentiel de gouvernance et d’évaluation des algorithmes (20) du secteur financier, avec un enjeu fort sur les principes d’explicabilité et d’intelligibilité. Toujours en 2020, la Haute Autorité de Santé (HAS) a proposé un outil pour l’évaluation des dispositifs médicaux embarquant de l’IA (21). D’autres secteurs ont rapidement suivi, comme l’industrie avec le consortium Confiance.ai (22), un « collectif d’acteurs académiques et industriels français des domaines de la défense, des transports, de l’industrie manufacturière et de l’énergie ». Suite à un appel à manifestation d’intérêt (AMI) courant 2021, le collectif a identifié 4 PME ou startups pour accompagner les entreprises du consortium dans le développement d’IA de confiance pour des cas d’usages industriels emblématiques. Le focus est ici porté sur les principes de robustesse technique et de cycle de vie des modèles.

Plusieurs labels voient également le jour. En 2020, l’association Arborus lance le label GEEIS-AI (24) pour l’égalité, la diversité et l’inclusion dans l’IA, sur le modèle de son label GEEIS (Gender Equality European & International Standard). Depuis 2021, l’association Labelia Labs (ex Substra Foudation) propose une démarche de labélisation (25) à deux niveaux de maturité distincts (intermédiaire ou avancé) suite à l’auto-évaluation en ligne des organisations volontaires. Quantmetry a notamment été labelisé en 2023 avec un niveau « avancé ». Plus récemment, le label Positive.ai (26) né en 2022 du travail des 4 entreprises co-fondatrices de l’association du même nom : Orange France, BCG GAMMA, L’Oréal et Malakoff Humanis. Ce label propose une première version de référentiel sur la base des principes d’équité et non-discrimination, explicabilité et contrôle humain avant d’élargir progressivement le périmètre aux autres principes de l’IA de confiance définis par l’UE dans son « Livre blanc sur une IA de confiance et d’excellence » (27) (2020).

Panorama non exhaustif des initiatives IA de confiance par typologie d’acteur, Quantmetry, janvier 2023

Conclusion

En synthèse, une grande diversité d’acteurs porte ces initiatives (régulateurs, organismes de normalisation et de certification, associations, etc.). Les principes de l’IA de confiance traités par chacune de ces initiatives sont complémentaires. Nous pouvons retenir qu’un large panel de référentiels, de grilles d’évaluation des niveaux de risques et de cadre légaux et normatifs viennent répondre à l’urgence de développer et déployer des systèmes d’IA de confiance dans l’ensemble des secteurs d’activité et au niveau mondial. Fortes de ces outils, même si ceux-ci sont multiples et non unifiés, les organisations européennes peuvent dès aujourd’hui s’emparer du sujet de l’IA de confiance en anticipant notamment la future mise en application de l’AI Act.

Notes de bas de page

- « Proposition de règlement du parlement européen et du conseil établissant des règles harmonisées concernant l’intelligence artificielle », Commission Européenne, avril 2021

- « Chiffre d’affaires prévisionnel du marché de l’intelligence artificielle dans le monde de 2016 à 2025 (en millions de dollars) », Statista Research Department, 2022

- « Baromètre des organisations Data 2022» regroupant les interviews de 53 dirigeants data interrogés sur la maturité data de leur organisation. Quantmetry, décembre 2022

- « L’intelligence artificielle dans la société. Chapitre 2 : Paysage économique de l’IA », OCDE, 2018

- « Accident de Tesla à Paris : le chauffeur de taxi porte plainte contre le constructeur américain », France bleu, mars 2022

- « Pays-Bas : le gouvernement chute après un scandale sur les allocations familiales », Libération, janvier 2021

- « Restitution de la consultation nationale sur la normalisation de l’intelligence artificielle », AFNOR, novembre 2021

- « Regulatory framework proposal on artificial intelligence », Commission Européenne, avril 2021

- « EU Draft Artificial Intelligence Regulation: Extraterritorial Application and Effects», European Law Blog, février 2022

- « OECD Framework for the Classification of AI Systems: a tool for effective AI policies ». OCDE, février 2022

- « Introduction d’un projet de régulation des algorithmes d’IA à l’échelle fédérale », Ambassade de France aux Etats-Unis, mars 2022

- « Bill C27, An Act to enact the Consumer Privacy Protection Act, the Personal Information and Data Protection Tribunal Act and the Artificial Intelligence and Data Act and to make consequential and related amendments to other Acts », House of Commons of Canada, juin 2022

- Fiche d’identité du groupe de travail « ISO/IEC JTC 1/SC 42, Intelligence artificielle », Iso.org

- « Information technology — Artificial intelligence (AI) — Use cases », ISO/IEC TR 24030:2021

- « Technologie de l’information — Intelligence artificielle (IA) — Tendance dans les systèmes de l’IA et dans la prise de décision assistée par l’IA », ISO/IEC TR 24027:2021

- « Information technology — Artificial intelligence — Overview of trustworthiness in artificial intelligence”, ISO/IEC TR 24028:2020

- “Artificial Intelligence (AI) — Assessment of the robustness of neural networks — Part 1: Overview”, ISO/IEC TR 24029-1:2021

- “Information technology — Artificial intelligence — Guidance on risk management”, ISO/IEC 23894

- “Certification de processus pour l’IA », LNE, 2021

- « Gouvernance des algorithmes d’intelligence artificielle dans le secteur financier », ACPR, juin 2020

- « Un nouvel outil pour l’évaluation des dispositifs médicaux embarquant de l’intelligence artificielle », HAS, octobre 2020

- Site de Confiance.ai

- MAPIE, A scikit-learn-compatible module for estimating prediction intervals. Quantmetry, Github

- « Le GEEIS, processus de labellisation pour l’égalité, la diversité, l’inclusion. Label GEEIS-AI », Arborus, septembre 2020

- « Plateforme d’évaluation Labelia IA responsable et de confiance », Labelia

- Site du label Positive.ai

- « Livre blanc de la Commission Européenne : une approche européenne axée sur l’excellence et la confiance », Commission Européenne, février 2020

Les membres de l’expertise Data & Strat définissent une stratégie data et mettent en place le plan opérationnel de transformation pour tirer le meilleur des données au service des enjeux et des objectifs business.

Les membres de l’expertise Reliable AI développent des modèles performants, fiables et maîtrisés, sur l’ensemble du cycle de vie, pour une IA de confiance.

Data Consultante Senior

Aurore Baehr est Data Consultante Senior au sein de Quantmetry qu'elle a rejoint en 2019 et fait partie de l'Expertise Reliable AI. Elle est également co-organisatrice du Meetup Paris Data Ladies, le meetup qui donne la parole aux femmes de la Data.